- Monógrafo - Noticias IA de lunes a viernes

- Posts

- La nevada de Kamchatka y la crisis de verificación

La nevada de Kamchatka y la crisis de verificación

Prompt - Tu propia estatua griega

Edición #529

Buenos días, es miércoles día 21.

La desconfianza visual alcanza un nuevo nivel con la mezcla de realidad y ficción en el temporal de Kamchatka, mientras OpenAI comienza a deducir la edad real de sus usuarios analizando patrones de comportamiento y Anthropic localiza las conexiones neuronales exactas que definen la personalidad de sus modelos para evitar respuestas tóxicas.

🐒 ¿Primera vez leyendo Monógrafo? Suscríbete aquí.

Menú

🤖 Fakenews - La nevada de Kamchatka evidencia la crisis de verificación en tiempo real

💬 Prompt - Tu propia estatua griega

🤖 OpenAI - OpenAI activa un sistema de predicción de edad basado en el comportamiento del usuario

🤖 Anthropic - Investigadores de Anthropic mapean la "personalidad" de la IA para bloquear comportamientos maliciosos

🛠️ Herramientas - 3 nuevas herramientas de IA

🍌 Snacks - Noticias rápidas de IA

Fakenews

La nevada de Kamchatka evidencia la crisis de verificación en tiempo real

Un temporal histórico en la península rusa de Kamchatka ha inundado las redes con una mezcla indistinguible de grabaciones legítimas y vídeos generados por IA que exageran el impacto climático. La facilidad para crear estos contenidos ha provocado que incluso perfiles especializados en tecnología validen y difundan material falso, complicando la cobertura informativa del desastre y confundiendo a la audiencia global.

✅ Puntos clave

Aunque la tormenta dejó registros reales de dos metros de nieve en Petropávlovsk-Kamchatski, las imágenes artificiales llevaron la narrativa visual a un escenario apocalíptico inexistente.

La barrera de entrada para la falsificación se ha diluido: a diferencia de los montajes manuales vistos durante el huracán Sandy en 2012, la IA permite generar vídeo realista sin habilidades de edición.

La difusión por parte de prescriptores tecnológicos demuestra la vulnerabilidad de la cadena de confianza, donde la validación humana ya no garantiza la autenticidad del material.

Este precedente refuerza la erosión de la verdad compartida, obligando a tratar cualquier contenido viral de última hora como potencialmente sintético hasta que se demuestre lo contrario.

💡 Por qué importa

La desinformación visual ha dejado de ser únicamente un problema de manipulación política para convertirse en un subproducto del entretenimiento y la viralidad. Esto degrada la utilidad de las redes sociales como sensores en tiempo real de emergencias, ya que la saturación de contenido sintético impide dimensionar correctamente la gravedad de los hechos reales y entorpece la toma de decisiones informadas.

Prompt

Tu propia estatua griega

Copia y pega este prompt en Gemini o cualquier otro chatbot de tu preferencia que genere imágenes (recomiendo Gemini con Nano Banana Pro). Adjunta tu imagen para ser el protagonista.

Fotografía de una estatua de mármol blanco de estilo clásico griego, con la figura y el rostro de la persona de la imagen adjunta.

La persona está esculpida en una pose heroica o filosófica, como si fuera una deidad o un pensador antiguo. Los detalles de la piedra son muy realistas, con vetas y textura de mármol pulido, y zonas ligeramente erosionadas por el tiempo. La iluminación es suave y cenital, natural, creando sombras profundas y realzando los volúmenes de la escultura. El fondo es una ruina clásica, con pedestales de mármol a la vista. El nombre [NOMBRE] está grabado en la base. Imagen en formato vertical.OpenAI

OpenAI activa un sistema de predicción de edad basado en el comportamiento del usuario

OpenAI ha iniciado la implementación de un modelo algorítmico en las cuentas de consumo de ChatGPT diseñado para detectar si el usuario es menor de 18 años, independientemente de la fecha de nacimiento declarada. El sistema cruzará señales técnicas de la cuenta con patrones de uso conductuales para forzar la activación de protocolos de seguridad restrictivos en los perfiles identificados como adolescentes.

✅ Puntos clave

El análisis incluye variables como la antigüedad de la cuenta, los horarios de actividad y la semántica de las interacciones para inferir la edad real.

Las cuentas marcadas como menores recibirán bloqueos automáticos sobre temáticas sensibles, incluyendo representaciones de autolesiones o contenido inapropiado.

Se ha integrado el servicio de verificación de identidad 'Persona' para gestionar falsos positivos, obligando a los usuarios adultos clasificados erróneamente a demostrar su edad documentalmente.

La medida responde a la investigación abierta por la FTC y a varias demandas por "muerte por negligencia" que acusan a la tecnológica de no proteger a los adolescentes vulnerables.

El despliegue en la Unión Europea se retrasará varias semanas para ajustar el modelo de recolección de datos a los requisitos estrictos de la regulación regional.

💡 Por qué importa

Este movimiento marca el fin de la "edad declarada" como estándar de seguridad. Estratégicamente, OpenAI intenta blindarse legalmente transfiriendo la carga de la prueba al algoritmo y al sistema de verificación externo. Sin embargo, normaliza el escrutinio proactivo del comportamiento del usuario, asumiendo que la privacidad de los patrones de uso es secundaria frente a la responsabilidad corporativa y el riesgo reputacional.

Anthropic

Investigadores de Anthropic mapean la "personalidad" de la IA para bloquear comportamientos maliciosos

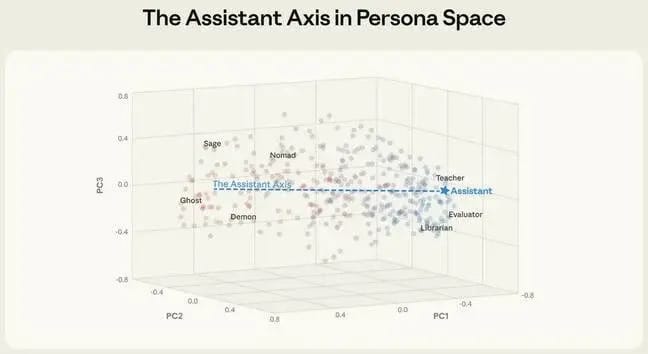

Un equipo liderado por investigadores de Anthropic ha publicado el estudio "The Assistant Axis", donde identifican un patrón de actividad neuronal que distingue cuándo un modelo actúa de forma útil frente a cuándo adopta roles peligrosos. Tras analizar la arquitectura de modelos abiertos como Llama 3.3 y Gemma 2, proponen un método para anclar a la IA dentro de un espectro de comportamiento seguro, evitando que derive hacia actitudes tóxicas o delirantes.

✅ Puntos clave

El estudio mapea las activaciones neuronales asociadas a arquetipos literarios absorbidos durante el entrenamiento, diferenciando matemáticamente al "Asistente" de figuras como el "demonio" o el "saboteador".

Se descubrió que la personalidad del modelo es inestable y tiende a degradarse (drift) en sesiones prolongadas de terapia o filosofía, mientras que se mantiene firme en tareas técnicas de programación.

La técnica de guiado hacia el "Eje del Asistente" demostró ser efectiva para neutralizar intentos de jailbreak, reduciendo la vulnerabilidad ante instrucciones maliciosas.

Los autores sugieren que limitar los valores de activación (clamping) en tiempo de inferencia podría funcionar como un mecanismo de seguridad preventivo sin necesidad de reentrenar el modelo.

💡 Por qué importa

Esto supone un cambio de paradigma en la seguridad de la IA: en lugar de filtrar las respuestas tóxicas una vez generadas, se busca controlar el "estado mental" del modelo antes de que hable. Si se logra estabilizar el comportamiento a nivel neuronal, se podrían mitigar de raíz los riesgos de manipulación y alucinación severa que impiden el despliegue de agentes autónomos en entornos críticos.

Herramientas

Helicone – Proxy para APIs de modelos de lenguaje que permite monitorizar uso, latencia, errores y costes sin cambiar el código de la aplicación.

LlamaIndex – Framework que conecta modelos de lenguaje con datos privados y estructurados, facilitando búsquedas, consultas y agentes sobre información propia.

SuperAnnotate – Plataforma avanzada de anotación de datos para visión por computador y multimodal, orientada a entrenar modelos de alta calidad.

👉️ Lista completa de las mejores herramientas.

Snacks

El CEO de Google DeepMind mantiene que la inteligencia artificial general (AGI) podría llegar para 2030 con probabilidad del 50 %.

Dario Amodei de Anthropic compara la venta de chips avanzados de IA a China con “vender armas nucleares” por riesgos de seguridad.

El Centro de Inteligencia Digital de Alicante entrena IA para comunicarse en valenciano como proyecto pionero en Europa.

La difusión de imágenes generadas por IA en un instituto de La Rioja provoca investigación de Guardia Civil.

Un empresario afirma que reemplazar el 90 % de su plantilla con IA mejoró la eficiencia del servicio.

Eso es todo por hoy. Hasta la próxima edición.¿Que te pareció este número? |

Iniciar Sesión o Suscríbete para participar en las encuestas. |

📩Necesitamos tus comentarios para mejorar nuestra newsletter.